Das Linux-Cluster der Leibniz Universität Hannover

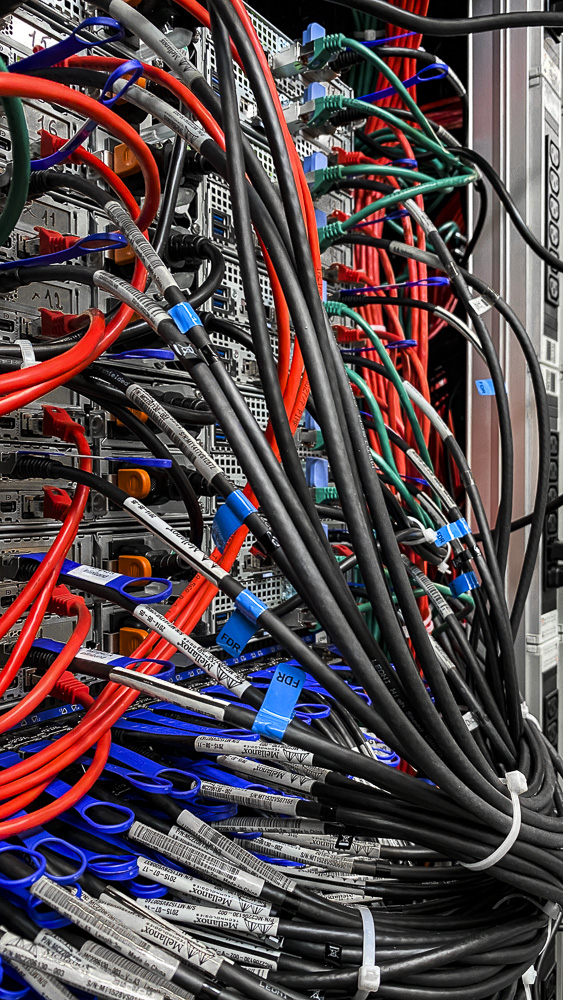

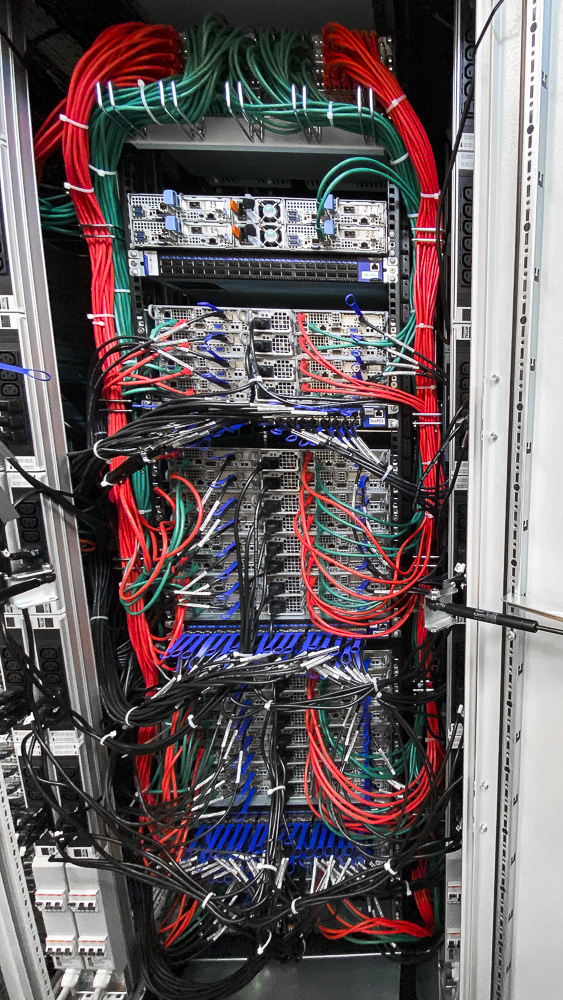

Mehr als 300 Server bilden das Linux-HPC-Cluster der größten Universität Niedersachsens, der Leibniz Universität Hannover. Ein Computing-Cluster für Forschung und Lehre, welches auf Commodity-x86-Hardware basiert (Mehr Infos gibt es hier!), die einzelnen Nodes über Infiniband-Spines miteinander verbindet und über Blade-Server und 2U4N-Chassis eine deutlich höhere Rechendichte pro Höheneinheit erreicht als klassische Hosting-Umgebungen. Entsprechend handelt es sich bei den Racks um außerordentlich dicht gepackte Systeme mit einer Vielzahl an Kabeln.

Für die auf zehn teils wassergekühlte Racks verteilten Server und Netzwerkkomponenten wurde es durch das stetige Wachstum eng im alten Rechenzentrum, sodass der Umzug in ein größeres Datacenter schließlich unausweichlich wurde.

Unsere Rolle als Spezialist für RZ-Umzüge

Hier kam die MP Next ins Spiel: Um die Downtime des Clusters so gering wie nur irgendmöglich zu halten, wurden wir als externer Dienstleister beauftragt, uns um den Ab- und Wiederaufbau des Equipments sowie um die Verkabelung der einzelnen Cluster-Nodes zu kümmern.

Unser Service

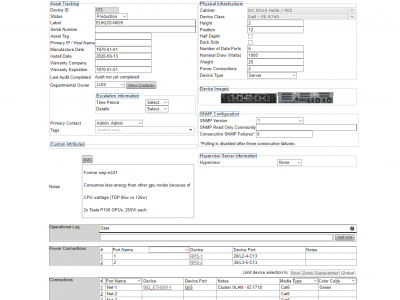

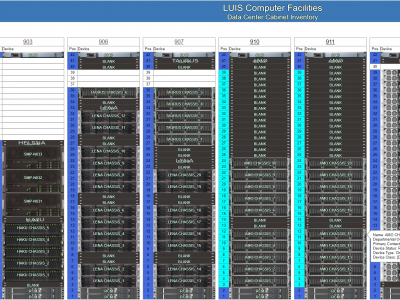

Nach einer detaillierten Vor-Ort-Begehung stand für uns fest: Wir halten den Umzug aller Server-, Storage und Netzwerkkomponenten inklusive Neuverkabelung innerhalb einer Arbeitswoche für realistisch machbar. Da die vorhandene Situation in den zehn Altracks nicht 1:1 übernommen werden sollte, sondern die Aufteilung der Cluster und Service-Infrastruktur am neuen Standort optimiert werden sollte, erstellte das Team der Leibniz Universität IT-Services (LUIS) im Vorfeld eine detailierte Planung der neuen Racks mittels openDCIM.

Zum vereinbarten Umzugstermin kümmerte sich unser Team aus erfahrenen IT-Fachkräften parallel um den Abbau der Serversysteme im alten Standort, organisierte den Transport in mehrfach gepolsterten Serverwannen und kümmerte sich zeitgleich am neuen Standort bereits um die Neuverkabelung. Im Vorfeld setzten wir für eine Relocation mit dieser Komplexität fünf Umzugstage an, wobei wir aufgrund der komplexen Cluster-Technik mit OmniPath- und Infiniband-Infrastruktur von vorneherein zwei weitere Tage als Notfallreserve bestimmt hatten. Von Kundenseite stand fest: Am vereinbarten Übergabetermin muss alles wieder laufen, egal was kommt!

Schlussendlich konnte unser Team die fertigen Racks bereits nach fünf Tagen fertiggestellt an den Kunden übergeben und alle Beteiligten konnten sich über ein ruhiges Wochenende freuen.